大家好,欢迎来到IT知识分享网。

方案选择

目前的方案基本上可以分为:

- LLM + Fine-tune: 对已有的大模型进行微调,这种方式成本高

- LLM + 外挂知识库: 就是本文章着重介绍的,简单的介绍可以看[大模型外挂(向量)知识库

源码

训练Word2Vec的教程和构建简单的知识库应用的代码都在这里(觉得不错的希望可以给个Star🌟,有问题可以提issue或在评论区留言)

环境搭建

Python

- 安装conda

brew install miniconda - 创建自定义虚拟环境

conda create -n [[name]] - 激活虚拟环境

conda activate [[name]] NLP相关依赖安装

自然语言处理,简称 NLP,是人工智能的一个分支,它允许机器理解、处理和操纵人类语言。

Pytorch

conda install pytorch Numpy

conda install numpy Scipy

conda install scipy Gensim

⚠️gensim依赖于scipy和numpy,一定要先安装前两者再安装gensim 是一个著名的开源 Python 库,用于从原始的非结构化的文本中,无监督地学习到文本隐层的主题向量表达。Gensim 支持包括TF-IDF,LDA和 word2vec在内的多种主题模型算法,因此很多算法工程师会将其作为主题建模的首选库。

conda install -c conda-forge gensim NLP基础概念

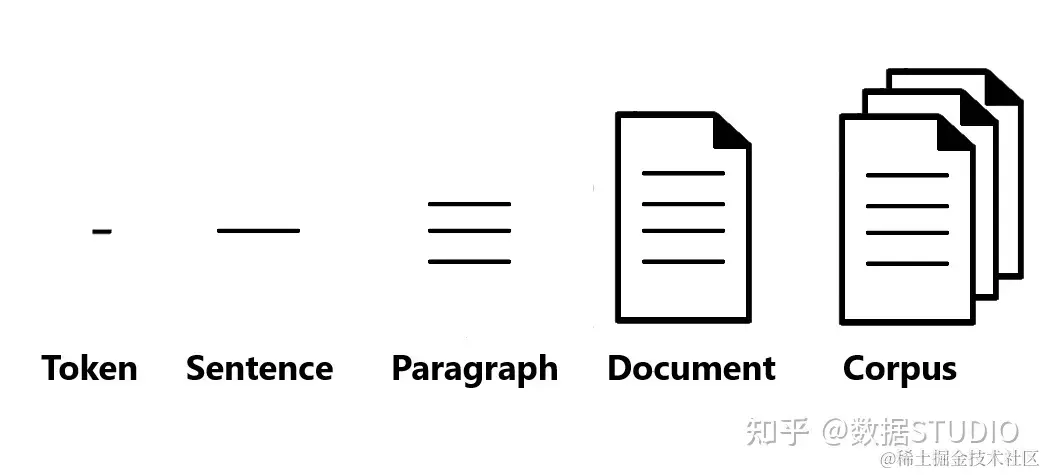

- 标记(Token): 是具有已知含义的字符串,标记可以是单词、数字或只是像标点符号的字符。“你好”、“123”和“-”是标记的一些示例。

- 句子(Sentence): 是一组意义完整的记号。“天气看起来不错” 是一个句子的例子,句子的标记是【“天气”, “看起来”, “不错“】。

- 段落(Paragraph): 是句子或短语的集合,也可以将句子视为段落的标记。

- 文档(Documents): 可能是一个句子、一个段落或一组段落。发送给个人的文本消息是文档的一个示例。

- 语料(Corpus): 通常是作为词袋的原始文档集合。语料库包括每个记录中每个单词的 id 和频率计数。语料库的一个例子是发送给特定人的电子邮件或文本消息的集合。

- 稀疏向量(SparseVector): 通常,我们可以略去向量中多余的0元素。此时,向量中的每一个元素是一个(index, value)的元组

- 模型(Model): 是一个抽象的术语。定义了两个向量空间的变换(即从文本的一种向量表达变换为另一种向量表达)。

模型介绍

Word2vec

Word2Vec是一种用于处理自然语言处理的模型,它是在2013年由Google的研究员Mikolov等人首次提出的。Word2Vec通过训练海量的文本数据,能够将每个单词转换为一个具有一定维度的向量。这个向量就可以代表这个单词的语义。因为这个向量是在大量语境中学到的,所以这个向量能很好的表达这个单词的语义。 Word2Vec包括Skip-Gram和CBOW两种模型,主要是通过优化模型计算词与词之间的关系,从而获得词的向量表示。 Skip-Gram模型是通过一个词预测其上下文。举个例子,给定词汇”苹果”,Skip-Gram模型的目标是生成它的上下文”吃了一个大”和”感觉真满足”。 CBOW模型是给定一个词的上下文词汇,预测这个词。比如,给定上下文”吃了一个大”和”感觉真满足”,CBOW模型会预测中间的词汇,也就是”苹果”。 这两种模型都是通过学习词汇与其上下文之间的关系,获得词的向量表示。这两个向量的距离可以用来衡量两个词语义上的相似度,距离越近意味着两个词语义上越相似。

同类型模型

word2vec模型已经很老了,本教程主要用于教学,让读者对大模型相关知识有一些实践的了解,故不强追求质量效率等。若读者感兴趣,可尝试其他词向量模型

- GloVe(Global Vectors for Word Representation):这是Stanford大学开发的一个词向量模型。不同于Word2Vec,GloVe会在全局的词频统计上进行建模从而生成词向量。因此会比Word2Vec更注重词与词之间的共现信息。

- FastText:这是Facebook AI研究团队开发的一种模型,它在Word2Vec的基础上进行了扩展。FastText不仅考虑整体词的信息,还考虑词中的子词信息。这使得FastText可以更好地处理词形变化以及拼写错误等问题。

- ELMo(Embeddings from Language Models):ELMo模型把词的语境信息也考虑在内,它认为每一个词的表示应依赖于整个输入的句子。通过这种动态的词向量,ELMo模型在很多NLP任务中达到了很好的效果。

- BERT(Bidirectional Encoder Representations from Transformers):这是Google在2018年提出的模型。BERT通过使用Transformer模型,对上下文进行双向全覓敵,从而对每个词生成更加丰富的向量表示。BERT在一系列的NLP任务中都取得了非常好的效果。

数据处理

中文wiki

[dumps.wikimedia.org/zhwiki/]

数据提取

按照具体数据集的规范解压提取出数据

数据处理

opencc

Open Chinese Convert(OpenCC)是一个开源的中文简繁转换项目,致力于制作高质量的基于统计语料的简繁转换词库。还提供函数库(libopencc)、命令行简繁转换工具、人工校对工具、词典生成程序、在线转换服务及图形用户界面。

pip3 install opencc-python-reimplemented 对于数据集我们需要依此进行四个操作:

- 过滤中文

- 简化中文

- 中文分词

- 除去停用词

其中繁体转简体 和 分词 所花费的时间 占大头

清华大学自然语言处理实验室数据集

[thuctc.thunlp.org/#%E6%A0%B7%…]

数据提取

我们下载的是.zip文件,先原地解压THUCNews.zip

数据处理

对于数据集我们需要依此进行四个操作:

- 过滤中文

- 简化中文

- 中文分词

- 除去停用词

数据合并

需要把所有数据集合并为一个数据集,作为最终训练模型用的数据集

模型训练

数据集并不大,m2 pro性能也很能打了,直接在本地硬造就行。 训练10轮,m2 pro 32g大约一个半小时可以完成

model = Word2Vec(sentences, vector_size=300, window=5, epochs=10, compute_loss=True, callbacks=[epoch_logger]) 模型使用

词向量生成

print(model.vector_size) print(model.total_train_time) print(model.wv.most_similar('猫')) print(model.wv.most_similar('吉林大学')) 结果:

300 4965.4 [('狗', 0.55566), ('猫咪', 0.3728), ('小猫', 0.97485), ('兔子', 0.28333), ('小狗', 0.51135), ('小猫咪', 0.63245), ('犬', 0.29565), ('宠物猫', 0.61133), ('吉娃娃', 0.83777), ('宠物狗', 0.02588)] [('东北师范大学', 0.99744), ('大连理工大学', 0.96533), ('哈尔滨工程大学', 0.99548), ('哈尔滨工业大学', 0.51721), ('西北农林科技大学', 0.8855), ('东北财经大学', 0.18213), ('中国医科大学', 0.8075), ('杭州大学', 0.35352), ('华东政法学院', 0.49268), ('白求恩医科大学', 0.46741)] 句向量生成

word2vec模型本身只能对词语进行embedding操作,如果想对句子进行embedding,有以下几种方法:

- 平均值:最简单的做法是将句子中所有词的向量进行平均。这会给你一个固定长度的向量,可以用作句子的embedding,但是这种方法不包含句子的语序信息。

- TF-IDF加权平均:与简单的平均法类似,但是每个词的权重与其在句子中的TF-IDF值成比例。这可以强调句子中更重要的词,但仍然不包含语序信息。

- Doc2Vec:这是一种在word2vec模型上进行了扩展,可以包含更大的上下文信息,即全文信息。Doc2Vec可以生成一个整体的句子向量,且保留了语序信息。

- 神经网络:可以使用深度学习模型,如RNN,GRU,LSTM或Transformer,这些模型可以利用word2vec词向量生成句子的嵌入向量,并且能捕捉到句子中的词序。

我们采用最简单的第一种方法

def encode(self, sentences: List[str], show_progress_bar: bool = False) -> ndarray: all_embeddings = [] for sentence in tqdm(sentences, desc='Word2Vec Embeddings', disable=not show_progress_bar): emb = [] count = 0 for word in sentence: # 过滤停用词 if word in self.stopwords: continue # 调用词向量 if word in self.w2v.key_to_index: emb.append(self.w2v.get_vector(word, norm=True)) count += 1 else: if len(word) == 1: continue # 再切分 ws = self.jieba.lcut(word, cut_all=True, HMM=True) for w in ws: if w in self.w2v.key_to_index: emb.append(self.w2v.get_vector(w, norm=True)) count += 1 tensor_x = np.array(emb).sum(axis=0) # 纵轴相加 if count > 0: avg_tensor_x = np.divide(tensor_x, count) else: avg_tensor_x = np.zeros(self.w2v.vector_size, dtype=float) all_embeddings.append(avg_tensor_x) all_embeddings = np.array(all_embeddings, dtype=float) if input_is_string: all_embeddings = all_embeddings[0] return all_embeddings 文档分块

- 固定大小分块

- 按内容划分

我们使用最简单的算法来对文档进行分句

def split_sentences(text): sent_delimiters = ['。', '?', '!', '?', '!', '.'] for delimiter in sent_delimiters: text = text.replace(delimiter, '\n') sentences = text.split('\n') sentences = [sent for sent in sentences if sent.strip()] return sentences 除此之外,还可以考虑使用以下库: pyltp(语言技术平台):pyltp是哈工大社会计算与信息检索研究中心研发的一款中文自然语言处理工具包,可以很好地处理中文文本。 pkuseg:pkuseg是北京大学的一个分词工具,也有一定的分句能力。 spaCy: spaCy是另一个用于NLP任务的强大Python库 NLTK: 自然语言工具包(NLTK)是一个流行的Python库,用于处理自然语言数据。

向量相似度计算

向量相似度的计算通常基于一种叫做余弦相似度(Cosine Similarity)的度量方法。余弦相似度直观地表示了两个向量间的夹角,其值越接近于1,表示两个向量越相似。

def cosine_similarity(vec1, vec2): norm_vec1 = numpy.linalg.norm(vec1) norm_vec2 = numpy.linalg.norm(vec2) if norm_vec1 == 0 or norm_vec2 == 0: return 0 else: dot_product = numpy.dot(vec1, vec2) return dot_product / (norm_vec1 * norm_vec2) 知识库检索

现在万事俱备,让我们来简单跑通一下这个流程

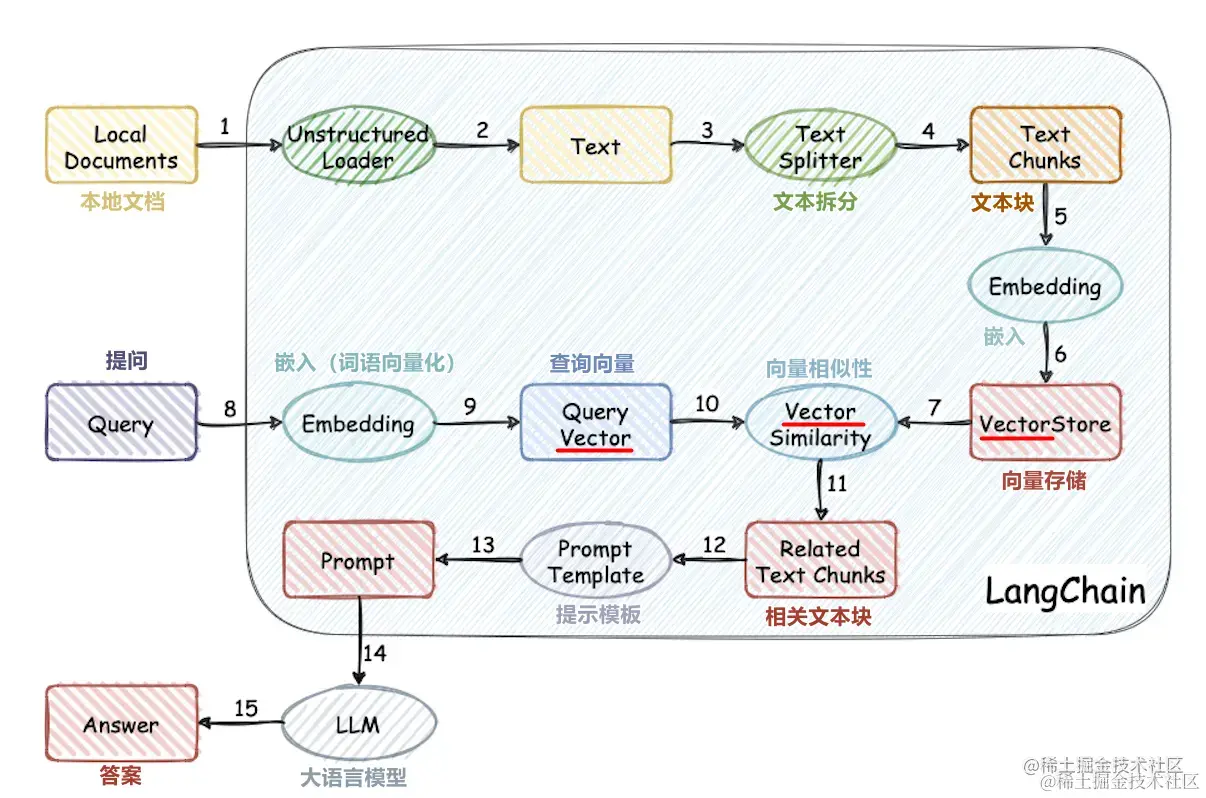

知识库端

- 将各类文档统一转为纯文本格式

- 文档分块

- 对各文档块进行向量化

- 将所有文本向量存储起来(持久化或非持久化均可)

查询端

- 将用户的查询语句向量化

- 将查询向量放入知识库进行相似性检索

- 获取检索到的向量,加入大模型的上下文中

- 获取大模型问答结果

将知识加入大模型上下文常用prompt模板:

使用以下背景段落来回答问题,如果段落内容不相关就返回未查到相关信息: 背景:{

{knowledge}} 问题:{

{userInput}} 向量数据库

定义

向量数据库是一种特殊类型的数据库,用于存储和检索向量嵌入以进行快速的相似性搜索。它们具有存储、查询和管理向量数据的能力,适用于各种应用,如语义搜索、图像识别、推荐系统等。向量数据库使用特殊的搜索技术,如近似最近邻搜索(ANN),以便在高维空间中查找最相似的向量。这些数据库还提供了数据管理、容错性、安全性和查询引擎等附加功能。

主流向量数据库

Pinecone

Pinecone是一个专门为工程师与开发者设计的向量数据库。 作为一个全托管的服务,它减轻了工程师以及运维人员的负担,使得客户可以聚焦于数据内在价值的抽取。

Weaviate

Weaviate 是一个开源的向量数据库,可以存储对象、向量,支持将矢量搜索与结构化过滤与云原生数据库容错和可拓展性等能力相结合。 支持GraphQL、REST和各种语言的客户端访问

Redis

redis 通过RedisSearch 模块,也原生支持向量检索。 RedisSearch 是一个Redis模块,提供了查询、二级索引,全文检索以及向量检索等能力。如果要使用RedisSearch,需要首先在Redis数据上声明索引。

Qdrant

面向下一代的生成式AI向量数据库,同时也具备云原生的特性。

Milvus

Chroma

一个开源的向量数据库。 可以快速基于Python和JavaScript构建内存级LLM应用

Zilliz

构建在Milvus之上的数据基础设施。

开源向量数据库对比

zilliz.com.cn/comparison

知识库持久化

如果我们想把知识库作为大模型的外接知识库,就需要借助向量数据库来存储之前被向量化的文档。我们选用Qdrant来部署(为了Rust!)

Qdrant部署

- 拉取docker镜像

docker pull qdrant/qdrant - Qdrant,启动!

docker run -p 6333:6333 -p 6334:6334 \ -v $(pwd)/qdrant_storage:/qdrant/storage:z \ qdrant/qdrant - 在python里调用Qdrant需要安装官方依赖

pip3 install qdrant-client from qdrant_client import QdrantClient client = QdrantClient("localhost", port=6333) ChatGLM大模型部署

本机配置

- Macbook m2 pro 32G

环境安装

创建虚拟&激活虚拟环境

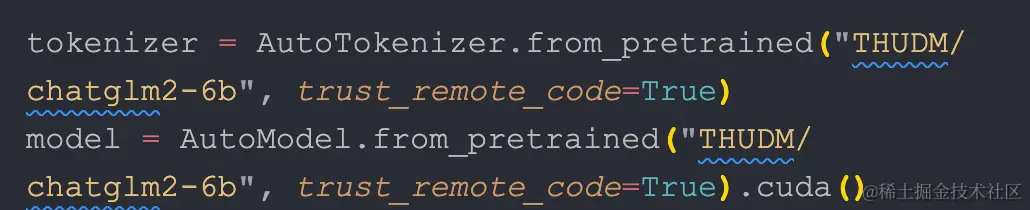

conda create -n chatglm python=3.10 conda activate chatglm 下载源码

cd /tmp git clone https://github.com/THUDM/ChatGLM2-6B 安装依赖

pip3 install -r requirements.txt # 安装 pytorch nightly 版本 pip3 install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cpu 下载模型文件

下载模型实现

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm2-6b 下载模型参数 [cloud.tsinghua.edu.cn/d/…] 将下载的文件替换到本地的 chatglm2-6b 目录下

部署模型

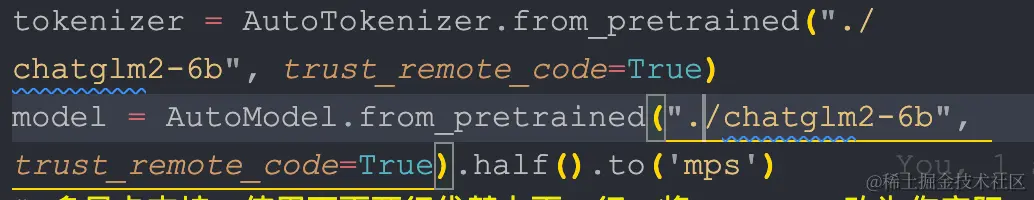

将模型下载到本地之后,将以上代码中的 THUDM/chatglm2-6b 替换为你本地的 chatglm2-6b 文件夹的路径,即可从本地加载模型。

对于mac,需要使用 mps 后端。同时需要修改模型的路径,修改为

python web_demo.py streamlit run web_demo2.py 参考

更多模型部署和使用参考官方文档 [github.com/THUDM/ChatG…]

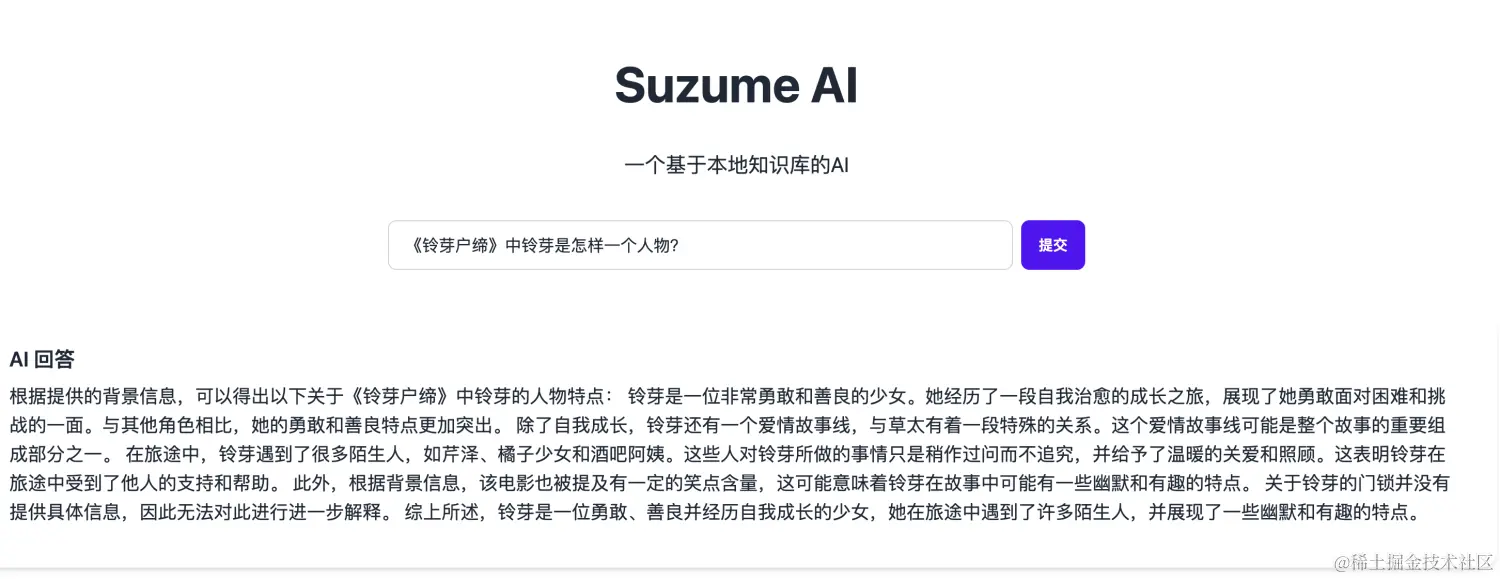

组合起来!

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://haidsoft.com/112858.html