大家好,欢迎来到IT知识分享网。

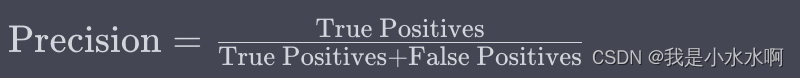

查准率(Precision):

查准率表示在所有被模型预测为正类别的样本中,有多少比例的样本实际上是正类别的。具体计算公式为:

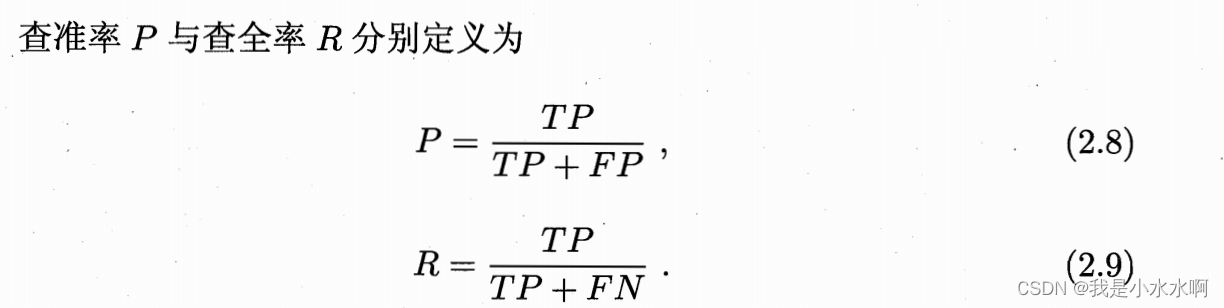

查全率(Recall):

F1分数(F1 Score):

实例

这里写一个二分类的问题来展示什么是查准率与查全率。

为什么我们要关注全差率,和查准率呢?

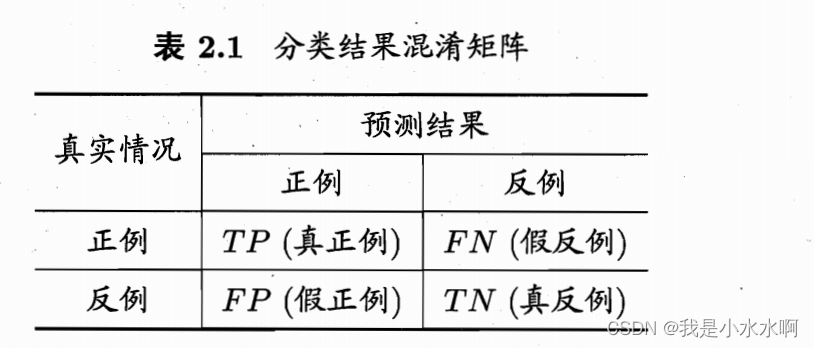

这里的表2.1 的混淆矩阵(代码实现不是二分类)可以用Python实现:

from sklearn.metrics import confusion_matrix import numpy as np # 示例的真实标签和预测标签 y_true = np.array([1, 0, 1, 2, 0, 1, 2, 3, 2]) y_pred = np.array([1, 0, 1, 2, 0, 2, 1, 3, 2]) # 计算混淆矩阵 conf_matrix = confusion_matrix(y_true, y_pred) # 输出混淆矩阵 print("Confusion Matrix:") print(conf_matrix) P-R曲线

F1度量

P:查准率 R:查全率 TP:真正列 TN:真反列 注意看:上面的表2.1

- (1)商品推销当中,为了尽量打扰用户,更喜欢退出的是用户感兴趣的此时查准率比较重要。

- (2)在抓捕逃犯信息当中,希望尽可能减少漏掉逃犯则这个时候查全率比较重要。

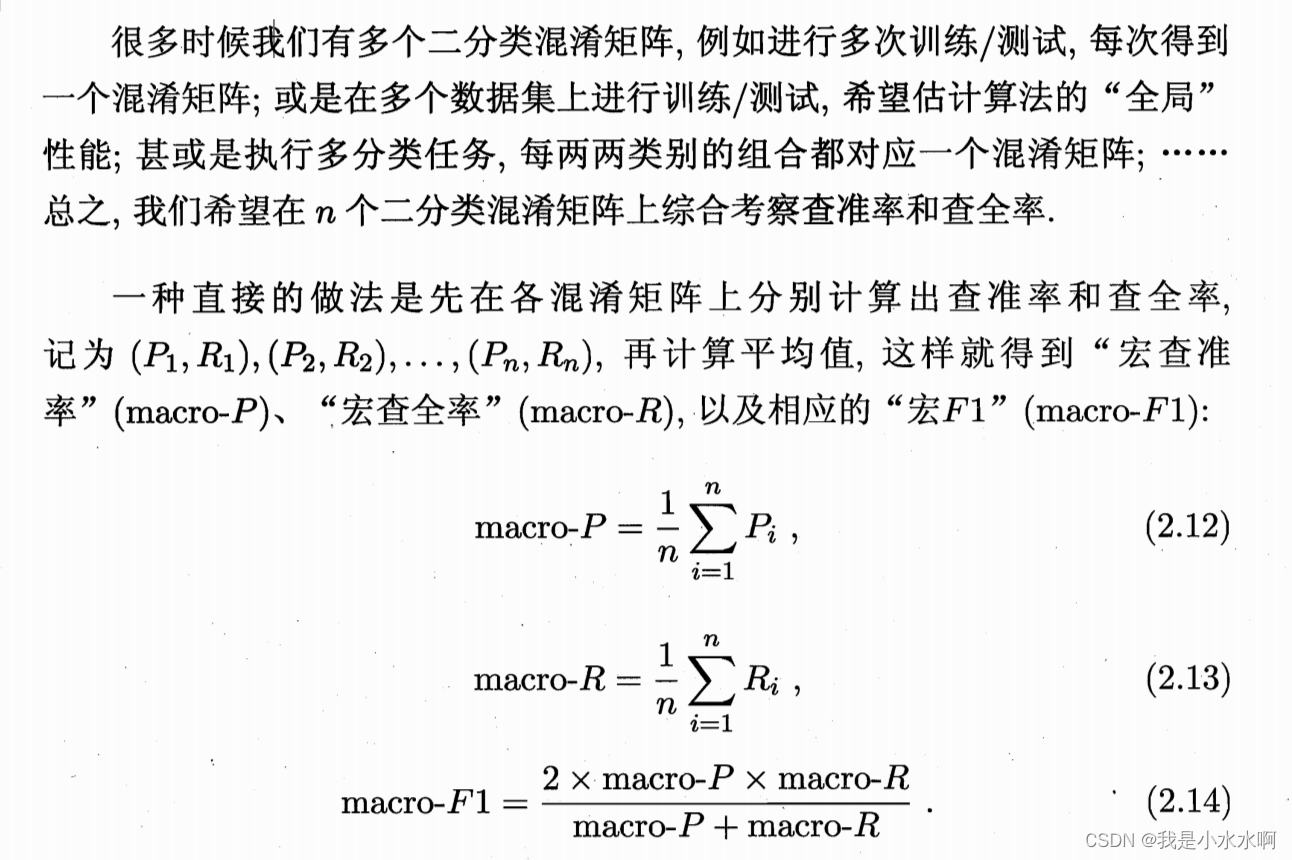

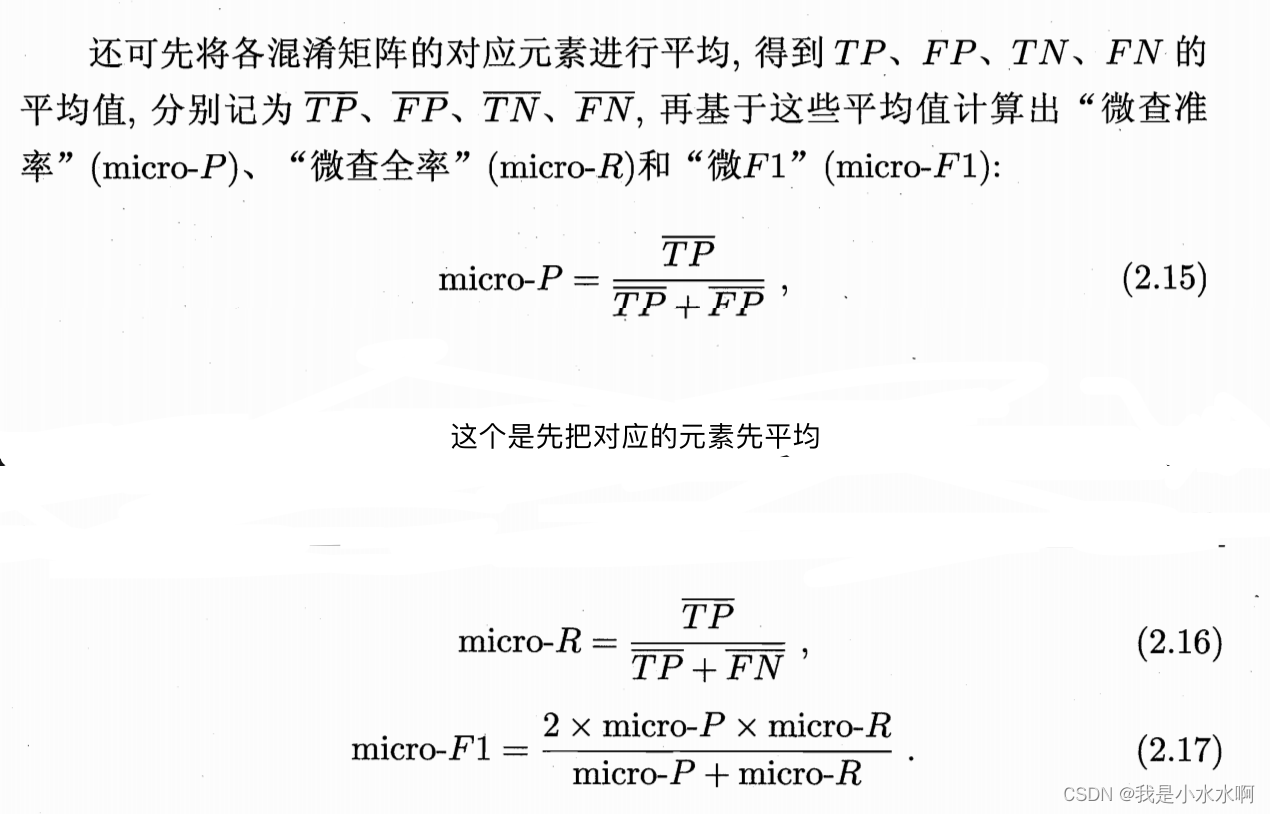

多次训练测试时取平均的F1(宏F1- mocro-F1)

python实现

P-R(Precision-Recall)曲线是一种用于可视化分类模型在不同阈值下查准率(Precision)和查全率(Recall)之间权衡关系的图形。以下是绘制P-R曲线的一般步骤:

- 计算不同阈值下的查准率和查全率: 使用不同的阈值将模型的预测概率转换为类别标签,然后计算每个阈值下的查准率和查全率。

- 绘制P-R曲线: 将计算得到的查准率和查全率值组成的点按照阈值的顺序绘制在二维坐标系上,横轴为查全率(Recall),纵轴为查准率(Precision)。

以下是一个Python示例代码,演示如何绘制P-R曲线,其中假设y_true为真实标签,y_scores为模型的预测概率。

= 这里也有阈值,就是thresholds ===

from sklearn.metrics import precision_recall_curve import matplotlib.pyplot as plt # 示例的真实标签和模型预测概率 y_true = [1, 1, 0, 1, 0, 1, 1, 0, 0, 1] y_scores = [0.8, 0.7, 0.4, 0.6, 0.3, 0.9, 0.5, 0.2, 0.1, 0.75] # 计算P-R曲线的查准率、查全率和阈值 precision, recall, thresholds = precision_recall_curve(y_true, y_scores) # 绘制P-R曲线 plt.figure(figsize=(8, 6)) plt.plot(recall, precision, marker='.') plt.xlabel('Recall') plt.ylabel('Precision') plt.title('P-R Curve') plt.grid(True) plt.show() 在这个例子中,precision_recall_curve函数会返回在所有可能阈值下的查准率、查全率和相应的阈值。然后,通过plt.plot()函数绘制这些点,就得到了P-R曲线。曲线上的每个点对应于一个特定的阈值,展示了在该阈值下模型的查准率和查全率。通常,P-R曲线越靠近右上角,表示模型在不同阈值下的性能越好。

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://haidsoft.com/113784.html