大家好,欢迎来到IT知识分享网。

1、什么是模型量化?

模型量化(Model Quantization)是指将深度学习模型中原本以高精度浮点数(如 FP32、FP16)存储和计算的权重、激活值等参数,转换为低比特宽度的数据类型(如INT8、INT4),以减少模型大小、降低计算开销,并提升推理速度。

通俗地说,模型量化就是让模型用“更粗的刻度”来表示和计算数值,从而提升运行效率、节省资源。

本质: 连续浮点数 → 离散定点整数

应用: 模型压缩、边缘部署、低功耗推理

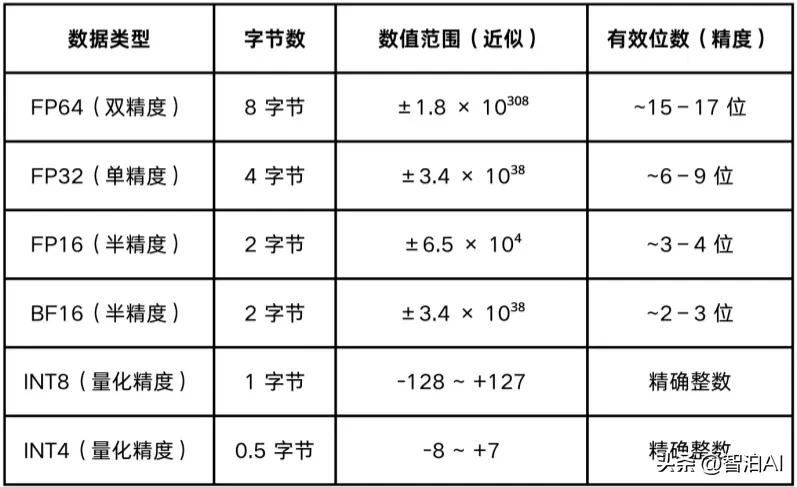

2、常见数据类型

3、模型量化的数学原理

模型量化通过“比例缩放+偏移”实现将连续浮点区间映射为有限的离散整数区间。

线性量化(最常见的量化算法)

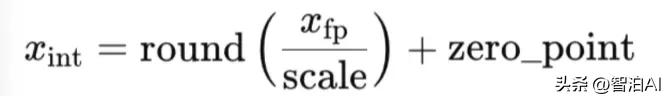

1 量化公式

x_fp: 原始浮点值

x_int: 量化后的整数值(如INT8)

scale: 缩放因子

zero_point: 用于对齐浮点值0的整数偏移

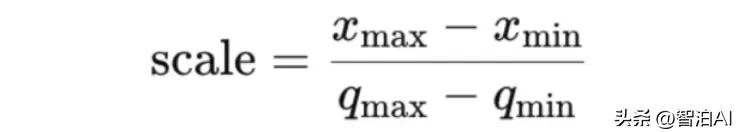

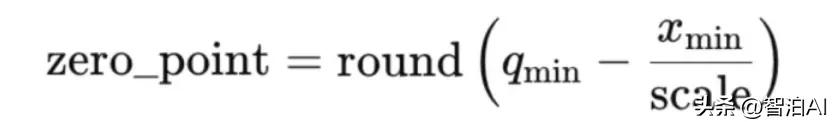

2 如何计算 scale 和 zero_point?

假设 x (即待量化的权重或激活值)的数值范围为[x_min,x_max],期望将其映射到整数范围:[q_min,q_max]。

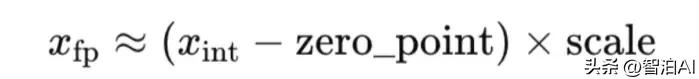

3 反量化公式

反量化的作用: 把量化后的整数还原为近似的浮点值,确保精度损失在可接受范围内,并且在推理时某些模块需要通过反量化将数据恢复成浮点数,映射回原始的数值空间。

举个例子:

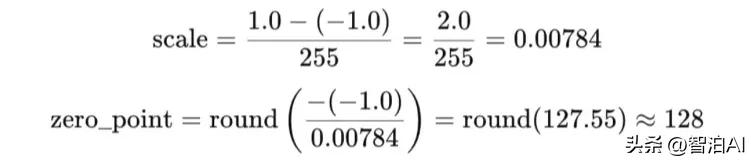

假设将[-1.0,1.0]的浮点区间映射到INT8,即[-128,127]

计算 scale 和 zero_point:

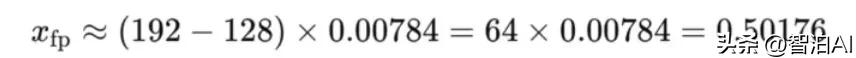

现要对 x_fp = 0.5 进行量化:

反量化:

说明: 反量化只能近似还原原始值,存在微小误差(这里是0.00176),这也是量化产生精度损失的来源之一。

4、模型量化的作用

压缩模型体积,减少显存占用: 低精度表示可显著压缩型体积,如 FP32 转INT4 可将显存占用减少约87.5%。

加速推理性能: 整数运算在多数硬件上效率更高,同时减少内存带宽需求和通信延迟,显著提升吞吐量与响应速度。

降低部署与运行成本: 显存与算力需求降低后,量化模型可在边缘设备上运行,延长电池续航、减少云端推理成本。

精度与性能的权衡: 量化会带来一定精度损失,但深度模型对小幅误差具备鲁棒性,合理设计可在几乎不影响准确率的前提下大幅加速模型。

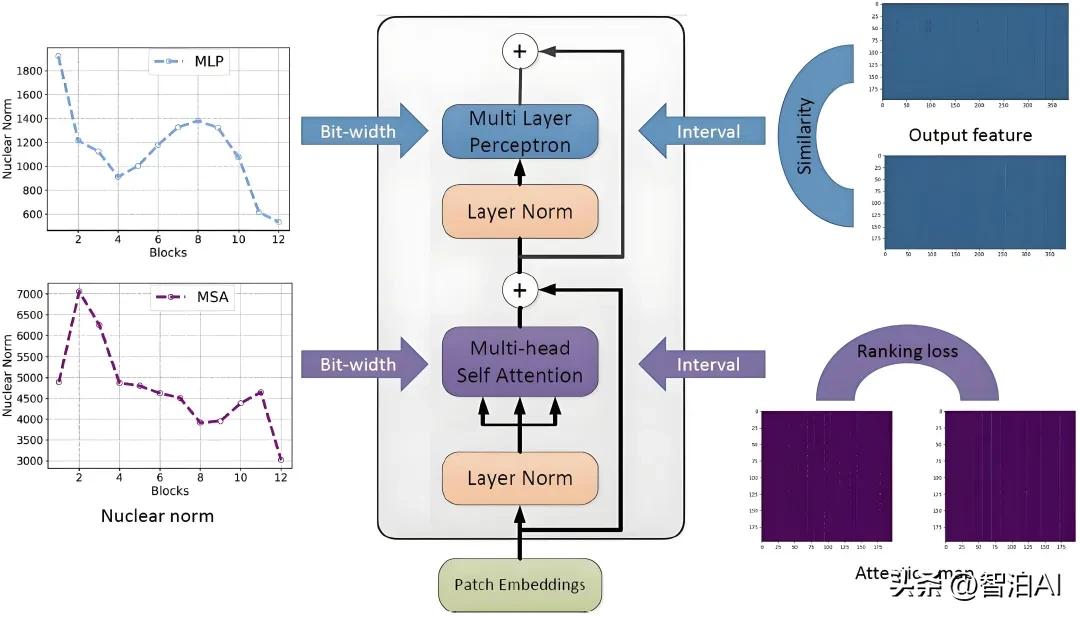

推理计算对比: 未经量化 VS 经过量化

未经量化: 全浮点计算

x_fp: 浮点输入

y_fp: 浮点输出

W_fp: 浮点权重

b: 浮点偏置

所有乘法和加法均为浮点运算,计算量大、速度慢。

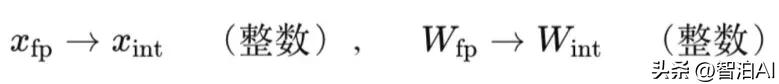

经过量化: 主要计算转为整数

预处理:

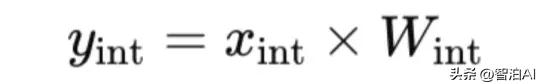

核心计算:

全为整数运算

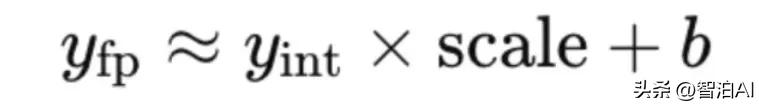

恢复输出:

仅在结果还原阶段使用少量浮点乘法

总结

经过量化,大部分乘法为INT x INT,浮点数计算量大幅下降,推理显著提速。

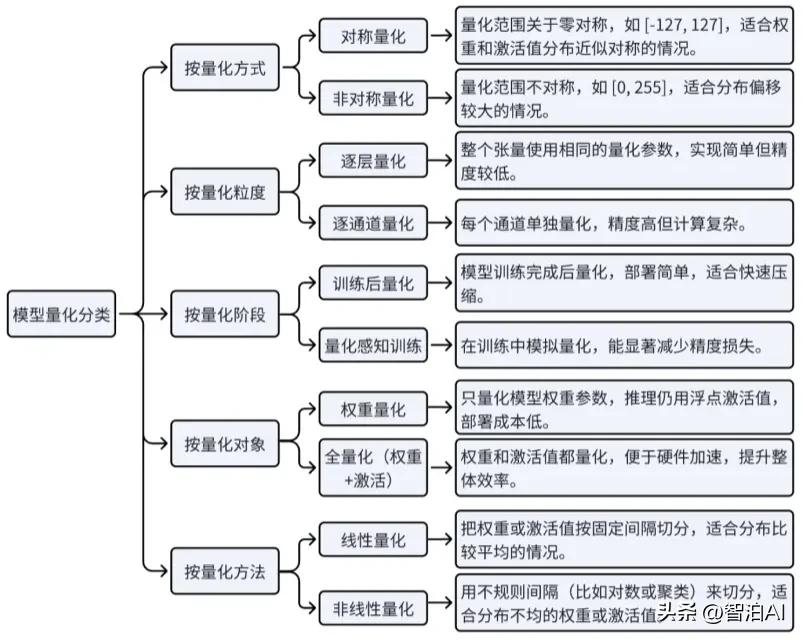

5、模型量化的分类

热门量化方法:

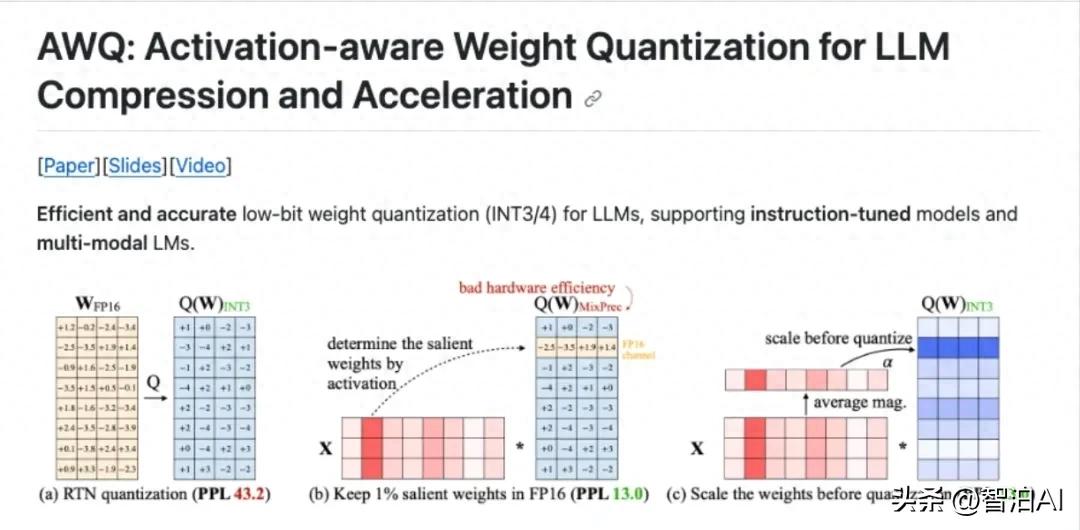

AWQ(激活感知量化): 不仅考虑型权重,还考虑激活值并根据它们对模型输出的影响程度,为重要权重分配更高的精度适用于对性能敏感的任务。

GPTQ(通用后训练量化): 一种训练后仅量化权重的方法对模型权重逐层量化,支持极低精度的量化,尤其适合资源受限的部署环境。

学习资源

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

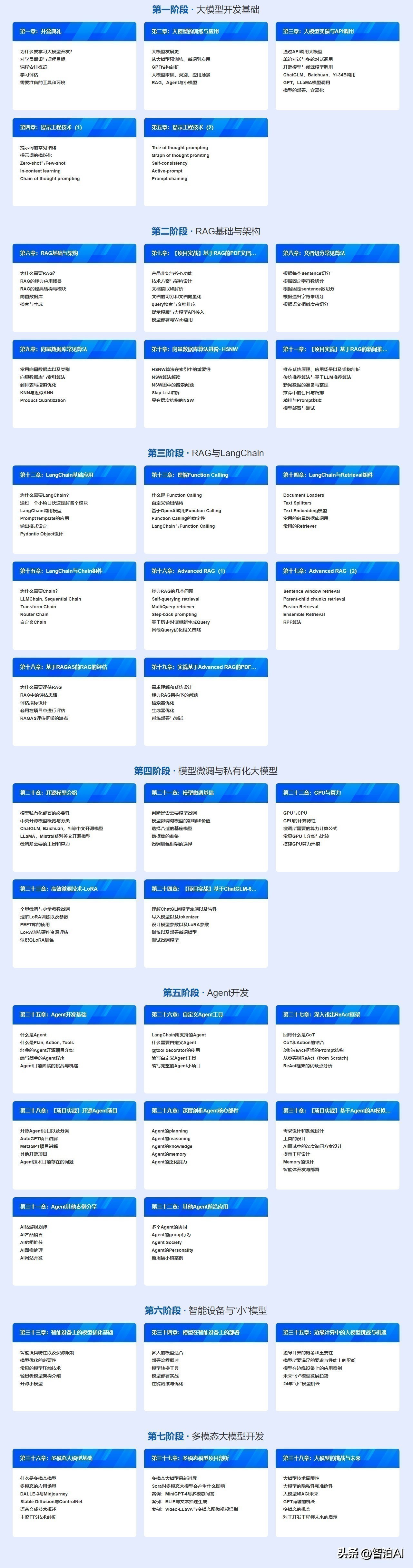

大模型从零基础到进阶的学习路线大纲全览

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

智泊AI:中国领先的人工智能(AI)平台和服务团队,致力于推动数字转型与智能升级,通过AI技术赋能未来人才发展。

PS:以上学习资源,@AI大模型元元小助理

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://haidsoft.com/185612.html