大家好,欢迎来到IT知识分享网。

1,GPU使用情况查看

在运行深度学习任务时,使用GPU训练是必不可少的,拥有强大的GPU资源并且合理利用可以使任务事半功倍。在利用GPU进行神经网络训练时,经常需要探查GPU利用情况,来判断是否合理使用了GPU进行网络训练。

在控制台使用命令nvidia-smi进行GPU资源利用率查看,Windows和Linux平台命令一样

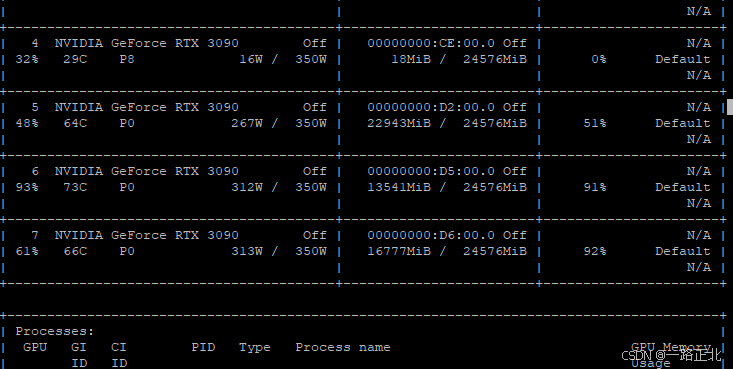

nvidia-smi会显示出如下界面

以4号GPU为例,详细解释一下界面显示的主要信息

- GPU编号:4,5,6,7

- GPU型号:NVIDIA GeForce RTX 3090

- GPU温度:查看时温度为29°C

- GPU功率:查看时功率为P8级,P0级时功率最高。目前工作功率16W,总功率350W

- GPU显存:总显存24576MiB,目前占用18MiB(基本上算是未使用)

- GPU利用率:查看时是0%

2,GPU使用情况分析

5号GPU:显存占用量大(22943MiB),但利用率较低(51%)。

6号和7号GPU:显存占用量小(13541MiB和16777MiB),但利用率较高(91%和92%)。

现象分析

显存占用量大但利用率低(5号GPU):

这种情况通常出现在加载了大量数据或模型参数到显存中,但这些数据或模型在当前时间段内并没有被频繁计算使用。也就是说,虽然显存中存储了大量数据或模型参数,但计算过程并没有很频繁地使用这些数据。

可能的原因包括:

模型的部分层次或模块只在某些特定阶段被计算。例如,在使用某些大模型时,某些层次可能只在训练或推理的某些特定阶段被激活,而其他时间则处于空闲状态。

数据加载/预处理阶段:如果在运行深度学习模型时,数据加载和预处理步骤消耗了大量的显存,而计算步骤较少,可能导致这种显存占用高而利用率低的情况。

显存占用量小但利用率高(6号和7号GPU):

这种情况表明,虽然显存占用相对较小,但GPU计算资源被频繁地调用,利用率较高。这通常发生在计算密集型任务上,例如在进行大量的矩阵运算或卷积操作时。

可能的原因包括:

计算密集型任务:模型的计算非常密集,例如深度卷积网络中的卷积操作。这些操作占用大量计算资源,导致GPU利用率高。

多GPU并行训练:如果多个GPU同时参与训练,可能模型的不同部分被分配到不同的GPU上进行计算,这样每个GPU虽然处理的数据不多,但计算任务很重。

可能的解释和解决方案:

数据不均衡分配:在多GPU训练中,数据或计算任务没有均匀分配,导致某些GPU任务较轻,利用率低,而其他GPU任务繁重,利用率高。可以检查你的数据分配策略,确保任务分布均匀。

网络架构或策略问题:有些网络架构会导致显存和计算资源的不均衡使用,例如模型并行策略导致部分GPU显存占用较多但计算较少。可以考虑优化并行计算策略或调整模型架构。

数据预加载问题:如果在5号GPU上加载了过多的数据或参数,导致显存占用高,但这些数据或参数没有被频繁使用,可能需要优化数据加载或分配策略,减少不必要的数据占用。

总结

5号GPU的显存占用高但利用率低,可能是由于大量的数据或模型参数加载到显存中,但没有被频繁使用或计算资源分配不均。

6号和7号GPU的显存占用小但利用率高,通常是因为这些GPU正在执行计算密集型任务,导致高利用率。

可以通过优化数据分配策略、平衡各GPU的任务负载来改善这一现象。

优化显存使用:有些网络设计或优化技巧,例如使用混合精度训练(Mixed Precision Training),可以减少显存占用,同时保持计算效率。

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://haidsoft.com/126381.html