大家好,欢迎来到IT知识分享网。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化学习资料的朋友,可以戳这里获取

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

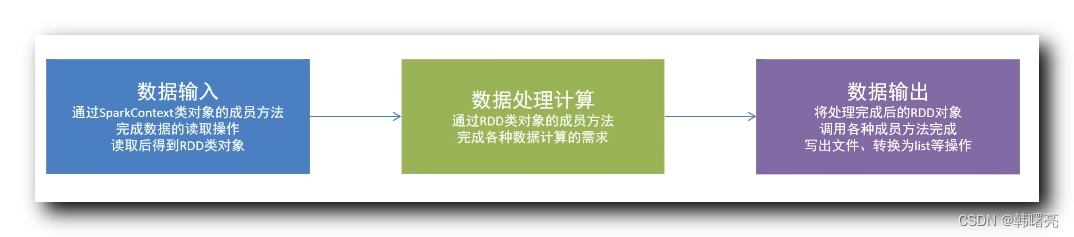

3、PyCharm 中安装 PySpark 也可以参考 [【Python】pyecharts 模块 ② ( 命令行安装 pyecharts 模块 | PyCharm 安装 pyecharts 模块 )]( ) 博客 , 在 PyCharm 中 , 安装 PySpark ; 尝试导入 pyspack 模块中的类 , 如果报错 , 使用报错修复选项 , PyCharm 会自动安装 PySpark ;  二、PySpark 数据处理步骤 --- PySpark 编程时 , 先要构建一个 PySpark 执行环境入口对象 , 然后开始执行数据处理操作 ; 数据处理的步骤如下 : 首先 , 要进行数据输入 , 需要读取要处理的原始数据 , 一般通过 SparkContext 执行环境入口对象 执行 数据读取操作 , 读取后得到 RDD 类实例对象 ; 然后 , 进行 数据处理计算 , 对 RDD 类实例对象 成员方法进行各种计算处理 ; 最后 , 输出 处理后的结果 , RDD 对象处理完毕后 , 写出文件 , 或者存储到内存中 ;  数据的初始形态 , 一般是 JSON 文件 , 文本文件 , 数据库文件 ; 通过 SparkContext 读取 原始文件 到 RDD 中 , 进行数据处理 ; 数据处理完毕后 , 存储到 内存 / 磁盘 / 数据库 中 ;  三、构建 PySpark 执行环境入口对象 --- 如果想要使用 PySpark 进行数据处理 , 必须构建一个 PySpark 执行环境入口对象 ; PySpark 执行环境 入口对象 是 SparkContext 类实例对象 ; 首先 , 导入相关包 ; 导入 PySpark 相关包

from pyspark import SparkConf, SparkContext

然后 , 创建 SparkConf 实例对象 , 该对象用于配置 Spark 任务 , 各种配置可以在链式调用中设置 ; * 调用 SparkConf#setMaster 函数 , 可以设置运行模式 , 单机模式 / 集群模式 ; * 调用 SparkConf#setAppName函数 , 可以设置 Spark 程序 名字 ; 创建 SparkConf 实例对象 , 该对象用于配置 Spark 任务

setMaster(“local[*]”) 表示在单机模式下 本机运行

setAppName(“hello_spark”) 是给 Spark 程序起一个名字

再后 , 创建 PySpark 执行环境 入口对象 ; 创建 PySpark 执行环境 入口对象

sparkContext = SparkContext(conf=sparkConf)

最后 , 执行完 数据处理 任务后 , 调用 SparkContext#stop 方法 , 停止 Spark 程序 ; 停止 PySpark 程序

sparkContext.stop()

四、代码示例 --- 代码示例 : 导入 PySpark 相关包

from pyspark import SparkConf, SparkContext

创建 SparkConf 实例对象 , 该对象用于配置 Spark 任务

setMaster(“local[*]”) 表示在单机模式下 本机运行

setAppName(“hello_spark”) 是给 Spark 程序起一个名字

创建 PySpark 执行环境 入口对象

sparkContext = SparkContext(conf=sparkConf)

打印 PySpark 版本号

print(sparkContext.version)

停止 PySpark 程序

sparkContext.stop()

执行结果 : 最后

不知道你们用的什么环境,我一般都是用的Python3.6环境和pycharm解释器,没有软件,或者没有资料,没人解答问题,都可以免费领取(包括今天的代码),过几天我还会做个视频教程出来,有需要也可以领取~

给大家准备的学习资料包括但不限于:

Python 环境、pycharm编辑器/永久激活/翻译插件

python 零基础视频教程

Python 界面开发实战教程

Python 爬虫实战教程

Python 数据分析实战教程

python 游戏开发实战教程

Python 电子书100本

Python 学习路线规划

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化学习资料的朋友,可以戳这里获取

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://haidsoft.com/128497.html