大家好,欢迎来到IT知识分享网。

CXL 概述

前言

CXL协议规范很新,目前没有多少资料,所以在学习过程中,肯定是需要笔记的,准备为此开一个专栏。以后会越来越详细,我尽量少用专业名词口语化去描述,让内容更加容易理解,以CXL 2.0 规范为纲,扩展开来,查漏补缺。点赞,收藏,转发。

1. 什么是CXL

1.1 背景

1.1.1 PCIE 的现状

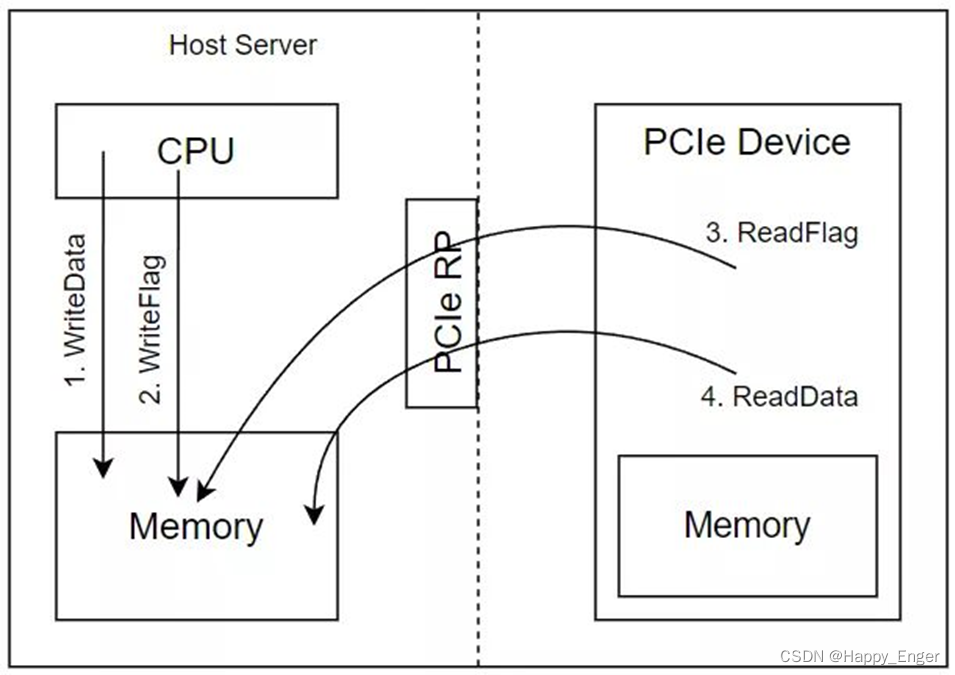

首先先看一下当前PCIE中的数据传输,无论是要创建一个PCIE内存扩展设备还是一个PCIE网卡,目前大数据量的传输都是采用生产者消费者模型,上图是说明主机向设备传输数据流程,主机要先把数据写到本地的内存,然后置标志位通知设备我写好了,设备查询标志位之后开始搬运数据到设备的本地内存,反过来是差不多的,这种方式的缺点也是显而易见的,有很多不必要的拷贝;PCIE协议可以实现主机直接访问设备内存,设备内存直接访问主机内存的,但是因为物理路径过长,以及缓存一致性问题,导致延迟很高,这样我们就会产生两个诉求:

- 第一个就是主机可以向访问本地内存一样访问设备内存 ;

- 另一个就是设备也可以高效的访问主机内存;

1.1.2 技术背景

这部分就比较书面化了,总结几点就是:

- 我们处于大数据时代,数据处理需求提升,下一代数据中心性能需求;

- 服务器等设备需要增加内存容量和带宽;

- 需要一个工业标准去同意市场,提供更灵活的编程模型;

总之就是一句话,PCIE协议下的主机与设备两个方向的传输可以有上面两个诉求,可以改进。

1.2 特点

就是这么宣传的,目前没有量化数据。为什么会低延时呢,可以参考 CXL 为什么比 PCIe 低延迟高带宽。

- 低延时

- 高带宽

1.3 是什么

那么到底什么是CXL?

- 首先,CXL 是基于 PCIE5.0发展而来的,运行在 PCIE 物理层上的,具有相同的电器特性,针对缓存和内存优化的一个新协议,也就是说,CXL设备是可以插在PCIE插槽的,底层会协商使用 PCIe 协议;也就是说,现在拿一个 CXL 设备我们插到一个PCIE卡槽上可以在PCIe模式下使用,并不会用 CXL 协议进行通信。

- CXL功能需要使用一个灵活的端口,这个端口可以根据链路层协商决定是采用PCIE协议还是CXL协议。所以如果一个支持PCIE功能的CXL设备,插到普通的不支持CXL的服务器上时,会协商决定只能使用PCIE协议。

这个端口就是 Flex Bus.

2. Flex Bus

想具体了解的可以去搜相关资料,这个不太是重点。只需要知道,要使用CXL功能,你的主机或者服务器得有 Flex Bus层,这个是CXL引入的。

2.1 特性

- 完全支持 PCIe 规范

- 完全支持 CXL 规范

- PCIe 和 CXL 可配置协议

- CXL 模式下速率 32GT/s, 16GT/s或者 8GT/s

- CXL 模式下链接宽度支持 X16, X8,X4,X2以及X1

2.2 Flex Bus 层级

上图为 CXL 的 Flex Bus(左) 与 PCIE 的层级(右)比较。

可以先不管其中的 .io, .mem, .cache, 后面会涉及。

如图,都分为三层:事务层、链路层、物理层。我们可以用TCP/IP 的七层协议类比一下,只不过这里是三层。

其中:

- CXL事务(协议)层和链路层 细分为处理 CXL.io 的逻辑和处理 CXL.mem 和 CXL.cache的逻辑;

- CXL.mem 和 CXL.cache 逻辑在事务层和链路层内组合在一起;

- CXL 链路层与物理层之间有一个 CXL (仲裁和多路复用)ARB/MUX 接口,交错来自两个逻辑流的流量;

- 物理层的逻辑子块是可以运行在PCIe模式和CXL模式,在链路训练过程中,模式取决于协商的结果;

3. 协议

- CXL.io

- CXL.mem

- CXL.cache

3.1 CXL.io

其中,CXL.io 协议和PCIe协议一样,是一种枚举配置协议,主要用于设备的发现和枚举、报告错误等,这个不算重点,剩下的两个才是。

3.2 CXL.mem

CXL.mem 协议,可以解决开头提出来的两个诉求之一

可以让主机像访问自己本地内存一样访问设备内存。

这个,很好理解,一个典型的例子就是我的CXL设备作为一个扩展内存插到服务器上,主机就通过此协议进行访问,就和其他DDR一样的,不过所用底层协议不一样。

3.3 CXL.cache

CXL.cache 协议,可以解决另一个诉求

可以使设备解决内存一致性,低延时的访问主机内存

PCIe 协议下,设备访问主机内存,无论是使用DMA还是直接访问,都会有cache一致性的问题,这方面不清楚的同学可以查询其他资料,简单地说就是,某一地址数据在主机的cache或者内存中,如果设备还要操作这个地址,那么就会出现很多复杂的操作。

CXL.cache 协议主要是通过维护设备侧Cache一致性, 提供快速访问主机内存的能力;它允许设备参与CPU的一致性缓存协议,就好像在整个系统中他是另外一个CPU而不是一个设备。.cache 协议就像CPU缓存一致性协议的一种延申。

他的目标是用在加速器上,这个加速器没有向系统提供任何资源相关的东西,但是可以直接使用系统内存和本地cache。设备具有一致的内存视图,无需软件干预,同样的,主机也可以从设备的 cache 中获取数据,不用使用内存作为中介了,使用 .cache 协议直接传输数据,保持一致性。

如下,是.cache协议的通道介绍:

H2D 主机到设备

D2H 设备到主机

两个方向,每个方向三种通道:请求、响应、数据,相互独立工作,详情请参考另一篇博文 CXL.cache

下面是一个 Type 1 设备读主机内存的例子,设备中只有缓存,没有内存:

- 设备主动发起读请求命令,缓存操作字段命令码为 RdOwn,表示读缓存行,并独占数据;

- 主机缓存命中,写回内存,并返回GO响应,其中的信息指示设备缓存转为E状态;

- 紧随GO消息之后,是主机返回数据,传到设备缓存;

3.4 Summary

4. 设备

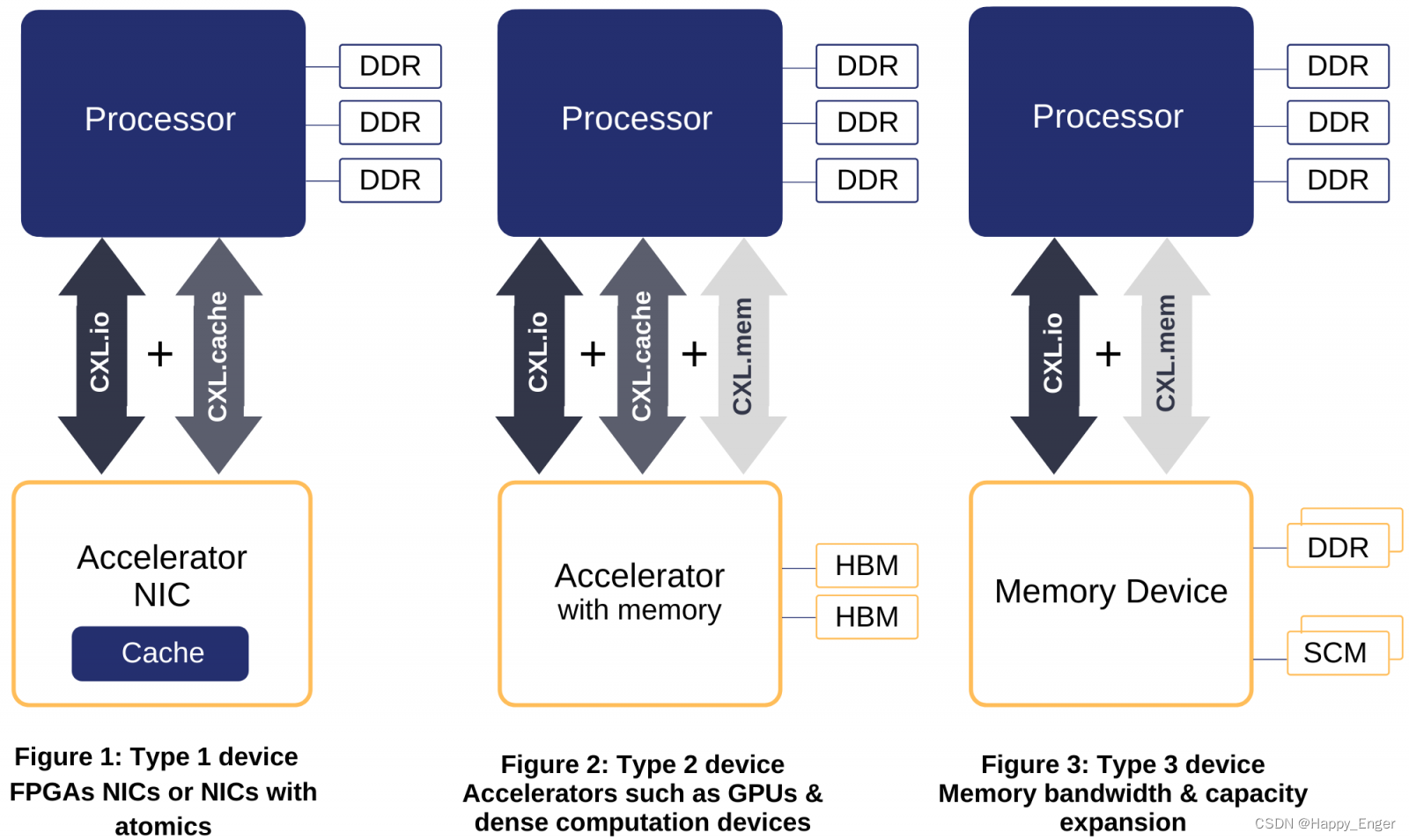

上面介绍了三种协议,对于一个CXL设备,.io是必备的,因为他是一个发现配置协议,.cache和.mem是可选的,这样就组合出三种类型的设备: Type 1, Type 2, Type3。

- Type 1 设备有cache,没有DDR,或者说他的内存是私有的,主机看不见,比如FPGA的网络接口控制器,他有访问主机内存的需求所以需要实现.cache 协议

- Type 2 设备既有cache也有内存,是一个带有内存的加速器,.cache和.mem协议都是需要的;

- Type 3 设备只有内存,没有cache,他作为一个内存扩展卡插到主机上,所以需要 .mem 协议;

4.1 Type 1

- 1类设备具有完全一致的缓存,可以实现无限数量的原子操作。是一个没有本地内存的加速器,没有本地内存的意思是Host 看不到,设备自己使用的内存可以根据需求添加;

- coherency Bridge 实现RC 片上一致性总线与 .cache 的转换

- 典型的应用是一个NIC,网络接口控制器,NIC 将数据从主机内存缓冲区中发送到网络上,或者从链路上把数据挪到主机内存接收缓冲区。PCIe 设备只能是从设备缓冲区拷贝数据包到主机接收缓冲区中,延迟高也占带宽,使用 .cache 协议,就直接写进缓冲区了,省了一步拷贝操作。

4.2 Type 2

- Type 2 设备是一个拥有本地内存的加速器,既有 cache 也有 memory, 缺一不可;

- CXL实现的是 Device的内存和Host的内存按照统一的编址方式进行寻址,主机可以直接将数据存放在设备内存中供加速器运算,然后直接获取运算结果,这样能够节省数据移动的时间开销;

- Type 2 设备必须实现自己的 DCOH 引擎(这将根据底层设备的缓存层次结构复杂度),用于维护缓存一致性的; 想象一下,与多个 CPU 相同,每个 CPU 都有自己的 L1/L2,但共享 L3(就像 Intel CPU 一样,L3 是 LLC)。 每个 CPU 都需要跟踪本地 L1 和 L2 之间的转换,以及 L3 到全局 L3 之间的转换。也就是说,对于类型 2 设备,管理本地的缓存状态是一个相对复杂的流程。

- 使用 Type 2 设备,HOST 把通过 .mem 协议数据放进 HDM, 这个是设备内存,然后设备对数据进行处理,结果可以通过 .cache 协议放进 Host 内存或者其他的,有点子绕;总之一句话,Host 操作设备内存,设备操作 Host 内存,都是低延时高带宽了,具体怎么应用是软件的事了。

4.2.1 操作模式

- 维护设备内存一致性

- 保证设备访问自己内存的时候带宽不会受到一致性影响

- 帮助主机更高效的访问设备内存

4.2.1.1 Host Bias

4.2.1.2 Device Bias

4.2.2 模式管理

- 软件协助可用于在加速器计算之前准备好数据

- 如果数据没有提前移动到加速器内存,一般是继续按需求基于加速器对数据的一些尝试移动

- 在“按需”数据获取场景中,加速器必须能够找到工作以执行,数据已正确放置,否则必须停止

- 加速器停滞的每个周期都会侵蚀其在核上运行的软件 add value 能力

- 简单的加速器通常不能隐藏数据获取延迟

- 和软件切换一样以页表为粒度维护bias state

- 不需要软件在执行offload excitation之前去识别页表的bias属性

- 硬件可以动态切换

- 虽然这是一种硬件驱动的解决方案,硬件也可以最终由软件触发bias切换

4.3 Type 3

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://haidsoft.com/136326.html